Manipulative Kommunikation bei Mensch und Maschine

Ein universelles Zeichen von höherer Intelligenz ist Kommunikation. Allerdings sind nicht alle Kommunikationen wohlwollend. Wie kann ein intelligentes System den Wahrheitsgehalt von Informationen erkennen und Betrugsversuche abwehren? Wie kann eine egoistische Intelligenz solch eine Abwehr unterlaufen? Welche Phänomene entstehen im Zusammenspiel von Täuschung und Abwehr? Um solche Fragen zu beantworten, haben Forscher am Max-Planck-Institut für Astrophysik in Garching, der Universität Sydney und dem Leibniz-Institut für Wissensmedien in Tübingen die soziale Interaktion von künstlichen Intelligenzen studiert und dabei sehr menschliches Verhalten beobachtet.

Wenn unser Gehirn eine Botschaft erhält, kann es diese in seinen Wissensschatz aufnehmen oder sie ignorieren. Letzteres ist beispielsweise dann angebracht, wenn starke Zweifel an der Wahrhaftigkeit der Botschaft bestehen. In diesem Fall sagt die Botschaft eventuell mehr über ihren Sender aus als diesem lieb sein könnte. Denn als Konsequenz von unglaubwürdigen Aussagen könnten andere den Sender als generell unglaubwürdig einstufen und ihm in Zukunft skeptischer begegnen. Dies würde die Effektivität seiner Kommunikation mindern. Daher sollte ein Sender von Botschaften daran interessiert sein, eine gute Reputation bezüglich seiner Glaubwürdigkeit zu haben.

Zwar kann man mit Ehrlichkeit tatsächlich eine gute Reputation erwerben, aber dies ist nicht der einzige Weg. Geschickt konstruierte Lügen, die nicht so leicht enttarnt werden können, können hierbei ebenfalls sehr erfolgreich sein. Sie bieten darüber hinaus dem Sender die Möglichkeit, für ihn besonders vorteilhafte Ansichten zu verbreiten. Auf Grund solcher Vorteile begleiten Lug und Trug die Menschheit vermutlich schon, seit sie zu sprechen begann.

Der Einsatz des Konzeptes von Reputation sowie auch deren Manipulation sollte keineswegs auf Menschen beschränkt sein. Praktisch jegliche Intelligenz, sei sie human, animalisch, künstlich, oder gar außerirdisch, sollte mit dem Dilemma nicht wahrheitsgetreuer, desinformierender oder gar bösartiger Kommunikation konfrontiert sein, existieren doch stets auch Vorteile beim Betrug. Daher ist zu erwarten, dass in jeglichen Gesellschaften von intelligenten Wesen das Konzept von Reputation entsteht, und auch dass über die Reputation der einzelnen Mitglieder der Gesellschaft kommuniziert wird. Weiterhin werden immer einzelne Mitglieder danach trachten, ihre Reputation zum eigenen Vorteil zu manipulieren. Zumindest scheint dies bei uns Menschen der Fall zu sein.

Reputation und Kommunikation über Reputation sollten also universelle Phänomene in jeglicher intelligenten Sozietät sein. Das Verständnis ihrer Dynamik ist wichtig, unter anderem auch im Hinblick auf problematische Entwicklungen in sozialen Medien. Dort kommunizieren heute mehr Menschen und mit größeren Reichweiten als jemals zuvor. Problematische Entwicklungen wie Polarisation und Abgrenzung von Gruppen scheinen von der Dynamik sozialer Medien befeuert zu sein.

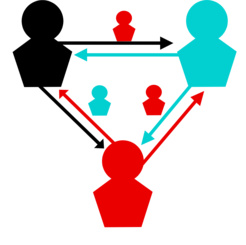

Zur Untersuchung solcher Dynamiken haben Torsten Enßlin und Viktoria Kainz vom Max-Planck-Institut für Astrophysik, Céline Bœhm von der Universität Sydney sowie Sonja Utz vom Leibniz-Institut für Wissensmedien eine Computersimulation von interagierenden künstlichen Intelligenzen geschaffen, die Reputation Game Simulation. Die dabei simulierten Intelligenzen, auch „Agenten“ genannt, sprechen miteinander, sind aber nicht notwendigerweise immer ehrlich (siehe Abbildung 1).

Die Agenten versuchen herauszufinden, wie ehrlich die anderen Agenten sind, aber auch, wie ehrlich sie selbst sind. Gleichzeitig sind die Agenten bestrebt, die anderen von ihrer eigenen Glaubhaftigkeit zu überzeugen. Hilfreich dazu sind aufwertende Lügen über sich selbst oder unterstützende Freunde sowie auch abwertende über Feinde. Allerdings birgt Lügen stets das Risiko, dabei ertappt zu werden. Neben verräterischen Anzeichen, die sich beim Lügen nicht immer vermeiden lassen, achten die Agenten auch darauf, wie plausibel eine Behauptung im Licht des eigenen Wissens ist und nutzen dies zur Bewertung der Glaubwürdigkeit der erhaltenen Botschaften. Je nach Bewertung wird eine Botschaft entweder als eher wahr akzeptiert und in das eigene Wissen integriert oder eher ignoriert, da potenziell irreführend. Im letzteren Fall wird allerdings der die Botschaft empfangende Agent dies als Betrugsversuch des Senders registrieren. Um die Komplexität der Simulation überschaubar zu halten, gestatten die Wissenschaftler den Agenten nur ein einziges Gesprächsthema, nämlich die Ehrlichkeit der verschiedenen Agenten. Diese tratschen also miteinander und übereinander.

Solche Simulationen von Klatsch und Tratsch sind in den sozialen Wissenschaften nichts Neues. Neu jedoch ist in der Reputation Game Simulation das weiter entwickelte kognitive System der Agenten, welches informationstheoretischen Prinzipien folgt. Die Agenten haben Meinungen, die entweder sehr fest oder auch recht unsicher sein können. Sie ziehen logische Schlüsse unter Berücksichtigung der Unsicherheit der erhaltenen Informationen. Die Agenten unterliegen dabei, wie wir Menschen, Beschränkungen in der Menge und Genauigkeit der Informationsverarbeitung. Die Agenten beobachten sich selbst und ihr Umfeld, und passen sich den herrschenden sozialen Stimmungen an. Dies erlaubt ihnen einerseits, typische Lügen besser zu erkennen und andererseits eventuell selber Lügen so zu entwerfen, dass diese sich erfolgreicher verbreiten.

Reputations- und Freundschaftsstatistik von Agenten in Simulationen des Reputation Games. Dargestellt sind die Beziehungen dreier Agenten. Agent Schwarz ist sehr ehrlich, Agent Türkis recht ehrlich, und Agent Rot ein chronischer Lügner. Das Diagramm oben links illustriert wie die anderen Diagramme zu lesen sind. Darin zeigt die rote Fläche mit türkis-farbiger Begrenzung an wie Agent Rot von Agent Türkis während einhundert Simulationen gesehen wurde. Agent Türkis sähe Agenten Rot gemäß diesem Diagramm als einen ehrlichen Freund. Die wirkliche Ehrlichkeit von Agent Rot ist niedriger und durch die rot gestrichelte Linie angezeigt. Das rechte obere Diagramm zeigt die wechselseitige Einschätzung der drei Agenten, wenn alle gewöhnlich sind, d.h. keine spezielle Strategie anwenden um ihre Reputation zu heben, sondern lediglich von Zeit zu Zeit lügen. Hier ist das Kassandra-Syndrom zu beobachten: Der tatsächlich ehrliche Agent Schwarz wird in vielen Simulationen als recht unehrlich wahrgenommen. In den unteren Diagrammen lügt Agent Rot immer und verfolgt spezielle Strategien. Unten links zeigt wie effizient die Strategie des Einschmeichelns ihm erlaubt als ehrlicher Freund der anderen zu erscheinen. Unten rechts betreibt Agent Rot penetrante Selbstanpreisung und erreicht damit öfters, aber nicht immer, eine sehr hohe Reputation.

Die Forscher haben anhand der Reputation Game Simulation eine Reihe von unterschiedlichen Kommunikationsstrategien daraufhin testen können, wie gut diese geeignet sind, den Agenten eine hohe Reputation zu verschaffen. Dabei zeigte sich, dass Ehrlichkeit zwar eine gute Strategie sein kann, aber weniger ehrliche Vorgehensweisen unter Umständen erfolgreicher sein können (siehe Abbildung 2).

Als verlässlich erfolgreich stellte sich in den Simulationen die Strategie des Einschmeichelns heraus (siehe Abbildung 2, links unten). Dies funktioniert besonders gut, wenn hauptsächlich eher weniger ehrliche Gestalten umschmeichelt werden. Diese werden dann in ihren häufigeren Lügen ihrem guten Kumpel, dem Schmeichler, einen sehr guten Leumund ausstellen.

Riskant, aber doch in vielen Fällen äußerst erfolgreich ist penetrantes Eigenlob, bevorzugt bei besonders glaubwürdigen und damit hochangesehenen Zeitgenossen (siehe Abbildung 2, rechts unten). Diese überzeugen dann mittels ihrer hohen Glaubwürdigkeit wiederum die anderen Agenten von der Aufrichtigkeit des sich selbst lobenden Agenten. In einer beachtlichen Anzahl der Simulationsläufe schafften es damit notorische Lügner, nicht nur als extrem ehrlich zu erscheinen, sondern auch letztendlich von der eigenen Ehrlichkeit überzeugt zu sein. Letzteres ist eine erstaunliche Selbsttäuschung, denn die Lügner registrieren sehr wohl jede ihrer eigenen Lügen. Aber die starke Lobpreisung durch die Schar ihrer überzeugten Anhänger gibt ihnen einen festen Glauben an das eigene Gutsein.

In den Reputation Game Simulationen lassen sich also eine Reihen von Phänomenen beobachten, die sich auch ganz ähnlich in der Soziologie und Psychologie finden. So konnten zum Beispiel das Auftreten von Echokammern, Selbsttäuschungen, Lagerbildung, toxische wie auch eingefrorene soziale Stimmungen, die Symbiose von Schurken, und das sogenannte Kassandra-Syndrom beobachtet werden. Letzteres bezeichnet den Effekt, dass der wahrhaftigsten Person unter Umständen am wenigsten geglaubt wird, da ihre Meinung zu sehr von dem Glauben der Gruppe abweicht und daher als Lüge wahrgenommen wird (siehe Abbildung 2, rechts oben).

Zwar scheint Forschung zu lügenden Maschinen fern ab der Astrophysik zu sein, die für Torsten Enßlin und Céline Bœhm noch immer der Forschungsschwerpunkt ist. Doch selbst bei ihren astrophysikalischen Datenanalysen nutzen diese Forscher automatisierte Verfahren zur Identifizierung von unglaubwürdigen Messinstrumenten und irreführenden Datensätzen. Es ist zu erwarten, dass mit der in Zukunft wachsenden Komplexität der Instrumente und der Datenbanken deren maschinell berechnete Reputation eine immer wichtigere Rolle spielen. Automatisierte Kommunikation über solche Reputation wäre dann maschineller Tratsch.

Torsten Enßlin ist Astrophysiker und Informationstheoretiker. Viktoria Kainz ist theoretische Physikerin und Beraterin für künstliche Intelligenz in industriellen Anwendungen. Céline Bœhm ist Astroteilchenphysikerin und Kosmologin. Sonja Utz ist Psychologin und Mediensoziologin.