Auf der Suche nach Schwächen im kosmologischen Standardmodell

Neue Computersimulationen verfolgen die Entstehung von Galaxien und die Entwicklung der großräumigen Struktur des Kosmos mit bisher unerreichter statistischer Präzision

Ein internationales Astrophysik-Team unter der Leitung des Max-Planck-Instituts für Astrophysik in Deutschland, der Harvard University in den USA und der Durham University im Vereinigten Königreich hat den ehrgeizigen Versuch unternommen, gleichzeitig die Entstehung von Galaxien und die großräumige Struktur im Kosmos in erstaunlich großen Regionen des Weltalls zu simulieren. Ihre Simulationen berücksichtigen zudem die geisterhaften Neutrinos und könnten dazu beitragen, die Masse dieser Elementarteilchen einzugrenzen. Die ersten Ergebnisse des „MillenniumTNG“-Projekts wurden soeben in einer Reihe von 10 Artikeln in der Zeitschrift Monthly Notices of the Royal Astronomical Society veröffentlicht. Die neuen Rechnungen tragen dazu bei, das kosmologische Standardmodell einem Präzisionstest zu unterziehen und die meisten Informationen aus den bevorstehenden kosmologischen Beobachtungen herauszuholen.

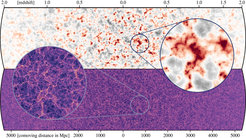

Projektionen von Gas (oben links), Dunkler Materie (oben rechts) und Sternenlicht (unten mitte) für eine Scheibe in der größten hydrodynamischen Simulation von MillenniumTNG zur gegenwärtigen Epoche. Der Ausschnitt ist etwa 35 Millionen Lichtjahre dick. Die Projektionen zeigen die enormen physikalischen Größenordnungen in der Simulation, von der maximalen Simulationsgröße, etwa 2400 Millionen Lichtjahre, bis zu einer einzelnen Spiralgalaxie (letzte, runde Vergrößerung) mit einem Radius von ~150 000 Lichtjahren. Die zugrundeliegende Berechnung ist die derzeit größte hochauflösende hydrodynamische Simulation der Galaxienentstehung und enthält mehr als 160 Milliarden Auflösungselemente.

In der Kosmologie hat sich in den letzten Jahrzehnten die verblüffende Annahme etabliert, dass die Materie im Universum von einer rätselhaften ‚Dunklen Materie‘ dominiert wird und dass ein noch seltsameres Feld aus ‚Dunkler Energie‘ als eine Art Anti-Schwerkraft wirkt, und die Expansion des heutigen Kosmos beschleunigt. Die gewöhnliche baryonische Materie trägt mit weniger als 5 % zum kosmischen Gemisch bei, dennoch bildet sie die Grundlage für die Sterne und Planeten in Galaxien wie unserer eigenen Milchstraße. Dieses seltsam anmutende kosmologische Modell wird LCDM genannt. Es liefert eine hartnäckig erfolgreiche Beschreibung einer Vielzahl von Beobachtungsdaten: von der kosmischen Mikrowellenstrahlung – der Restwärme, die der heiße Urknall hinterlassen hat – bis hin zum „kosmischen Netz“, in dem die Galaxien entlang eines verschlungenen Netzes mit Filamenten aus Dunkler Materie angeordnet sind.

Die tatsächliche physikalische Natur der Dunklen Materie und der Dunklen Energie ist jedoch immer noch nicht verstanden, weshalb Astrophysiker und Astrophysikerinnen nach Defiziten in der LCDM-Theorie suchen. Fänden sich Ungereimtheiten im Vergleich zu Beobachtungsdaten so könnte dies zu einem besseren Verständnis dieser grundlegenden Rätsel unseres Universums führen. Empfindliche Tests sind erforderlich, die beides brauchen: aussagekräftige neue Beobachtungsdaten und detailliertere Vorhersagen darüber, was das LCDM-Modell tatsächlich impliziert.

Forschenden am Max-Planck-Institut für Astrophysik (MPA) ist es nun zusammen mit einem internationalen Team der Harvard University und der Durham University sowie der York University in Kanada und des Donostia International Physics Center in Spanien gelungen, bei der theoretischen Beschreibung einen entscheidenden Schritt voranzukommen. Aufbauend auf ihren früheren Erfolgen mit den Projekten „Millennium“ und „IllustrisTNG“ entwickelten sie eine neue Reihe von Simulationsmodellen mit dem Namen „MillenniumTNG“, die die Physik der kosmischen Strukturbildung mit wesentlich höherer statistischer Genauigkeit nachzeichnen, als dies mit früheren Berechnungen möglich war.

Große Simulationen mit neuen physikalischen Details

Das Team nutzte den fortschrittlichen kosmologischen Rechen-Code GADGET-4, der speziell für diesen Zweck am MPA entwickelt wurde, um die bisher größten, hochaufgelösten Dunkle-Materie-Simulationen zu berechnen, die eine Region von fast 10 Milliarden Lichtjahren abdecken. Darüber hinaus verwendeten sie den hydrodynamischen Code AREPO, dessen Zellgröße sich dynamisch anpasst, um die Prozesse der Galaxienbildung direkt in so großen Volumina zu verfolgen, dass sie als repräsentativ für das gesamte Universum angesehen werden können. Aus dem Vergleich der beiden Arten an Simulation kann genau bewertet werden, wie sich baryonische Prozesse im Zusammenhang mit Supernova-Explosionen und supermassereichen Schwarzen Löchern auf die Gesamtverteilung der Materie auswirken. Dies wiederum erlaubt kommende Beobachtungen korrekt zu interpretieren, wie z. B. die so genannten schwachen Gravitationslinseneffekte. Diese reagieren auf Materie unabhängig davon, ob sie dunkel oder baryonisch ist.

Außerdem bezog das Team massereiche Neutrinos in seine Simulationen ein – zum ersten Mal in Simulationen, die groß genug sind, um kosmologische Beobachtungen aussagekräftig nachzustellen. In früheren kosmologischen Simulationen wurden Neutrinos meist der Einfachheit halber weggelassen, da sie höchstens 1-2 % der Masse der Dunklen Materie ausmachen und ihre nahezu relativistischen Geschwindigkeiten ein Zusammenklumpen verhindern. Nun aber werden künftige kosmologische Durchmusterungen des Universums (wie mit dem kürzlich gestarteten Euclid-Satelliten der Europäischen Weltraumorganisation) eine Genauigkeit erreichen, die einen Nachweis der damit verbundenen prozentualen Effekte ermöglicht. Dies eröffnet die verlockende Aussicht, die Neutrinomasse selbst zu bestimmen, eine grundlegende, offene Frage in der Teilchenphysik – es steht viel auf dem Spiel.

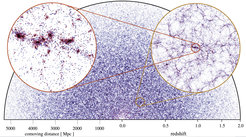

Vergleich der Verteilungen von Neutrinos (oben) und Dunkler Materie (unten) auf dem rückwärts gerichteten Lichtkegel eines Beobachters, der sich in der Mitte der beiden horizontalen Streifen befindet. Da die kosmische Ausdehnung die Neutrinos zu späten Zeiten verlangsamt (kleine Rotverschiebung/Entfernung), beginnen sie sich ein wenig um die größten Konzentrationen Dunkler Materie zu sammeln, wie ein Vergleich der beiden Zooms zeigt. Dies erhöht geringfügig die Masse und die weitere Wachstumsrate dieser größten Strukturen.

Für die bahnbrechenden MillenniumTNG-Simulationen nutzten die Forscher zwei extrem leistungsstarke Supercomputer: den SuperMUC-NG am Leibniz-Rechenzentrum (LRZ) in Garching und den Cosma8-Rechner, der von der Durham University im Auftrag der britischen DiRAC-Hochleistungsrechenanlage betrieben wird. Mehr als 120 000 Rechnerkerne arbeiteten am SuperMUC-NG fast zwei Monate lang, wobei die vom deutschen Gauß-Zentrum für Hochleistungsrechnen (GCS) zur Verfügung gestellte Rechenzeit genutzt wurde, um das bisher umfassendste hydrodynamische Simulationsmodell zu erstellen. MillenniumTNG verfolgt die Entstehung von etwa einhundert Millionen Galaxien in einer Region des Universums mit einem Durchmesser von etwa 2400 Millionen Lichtjahren (siehe Abbildung 1). Diese Berechnung ist etwa 15 Mal größer als die bisher beste in dieser Kategorie, das TNG300-Modell des IllustrisTNG-Projekts.

Mit Cosma8 berechnete das Team ein noch größeres Volumen des Universums, das mit mehr als einer Billion Teilchen der Dunklen Materie und mehr als 10 Milliarden Teilchen gefüllt ist, um den massereichen Neutrinos zu folgen (siehe Abbildung 2). Obwohl diese Simulation die baryonische Materie nicht direkt verfolgte, können die Galaxien in MillenniumTNG mit Hilfe eines semi-analytischen Modells, das gegen die baryonische Berechnung des Projekts kalibriert wird, genau vorhergesagt werden. Dieses Verfahren führt zu einer detaillierten Verteilung der Galaxien und der Materie in einem Volumen, das zum ersten Mal groß genug ist, um für das gesamte Universum repräsentativ zu sein, so dass Vergleiche mit bevorstehenden Beobachtungen auf eine solide statistische Grundlage gestellt werden können.

Theoretische Vorhersagen für die Kosmologie

Die ersten Ergebnisse des MillenniumTNG-Projekts zeigen eine Fülle von neuen theoretischen Vorhersagen, die die Bedeutung von Computersimulationen in der modernen Kosmologie unterstreichen. Das Team hat zehn wissenschaftliche Paper für das Projekt verfasst und eingereicht. Acht davon sind soeben in der Fachzeitschrift MNRAS erschienen, die beiden anderen werden in Kürze folgen.

Eine der Studien beschäftigte sich mit der Form von Galaxien. Nahe Galaxien haben die subtile Tendenz, ihre Formen ähnlich auszurichten anstatt in willkürliche Richtungen zu zeigen – ein Effekt, der „intrinsische Galaxienausrichtung“ genannt wird. Dieser kaum erforschte Effekt verzerrt die Ergebnisse, die sich aus dem schwachen Gravitationslinseneffekt ergeben, der ja sein eigenes statistisches Ausrichtungssignal erzeugt. Im Rahmen des MillenniumTNG-Projekts konnten zum ersten Mal intrinsische Ausrichtungen mit einem sehr hohen Signal-Rausch-Verhältnis direkt bei den simulierten Galaxien gemessen werden, und zwar bis zu Entfernungen von mehreren hundert Millionen Lichtjahren. „Unsere Bestimmung der intrinsischen Ausrichtung von Galaxien kann vielleicht dazu beitragen eine Diskrepanz aufzulösen, die derzeit zwischen zwei Methoden herrscht, um die Amplitude zu messen, wie stark Materie klumpt“, sagt die Doktorandin Ana Maria Delgado, Erstautorin dieser Studie im MillenniumTNG-Team. „Die Materie-Anhäufung wird dabei einmal über den schwachen Gravitationslinseneffekt bestimmt und einmal aus dem kosmischen Mikrowellenhintergrund abgeleitet.“ Mit Hilfe der MillenniumTNG-Ergebnisse werden die Astronomen in der Lage sein, diesen wichtigen systematischen Effekt viel besser zu korrigieren.

Galaxienverteilung auf dem rückwärts gerichteten Lichtkegel in MillenniumTNG, wobei die Galaxien mit einem ausgeklügelten semi-analytischen Modell auf dem Rückgrat der Dunklen Materie vorhergesagt werden. Die Galaxien sind bis zur scheinbaren Helligkeit von Johnson 𝑅 < 23 in einem 180 Grad breiten, dünnen Keil mit einem Öffnungswinkel von 0,24 Grad bis zur Rotverschiebung 𝑧 = 2 dargestellt. Die Positionen der Galaxien sind als Kreise mit Koordinaten im realen Raum eingezeichnet, wobei die Farbe Rot für Galaxien mit einem Farbindex 𝐵-𝑅 > 0,7 verwendet wird und ansonsten Blau. Reale Beobachtungen der Galaxienpositionen würden zusätzlich durch kleine Verschiebungen entlang der Sichtlinie aufgrund von Dopplereffekten durch die Bewegungen der Galaxien gestört, ein Effekt, der ebenfalls leicht in den Modellen berücksichtigt werden kann. Die beiden kreisförmigen Einschübe zeigen verschachtelte Zooms mit Durchmessern von etwa 1,25 Milliarden und 125 Millionen Lichtjahren und den schwächeren scheinbaren Helligkeitsgrenzen von 𝑅 < 25 bzw. 𝑅 < 28.

Ein weiteres aktuelles Ergebnis bezieht sich auf die jüngste Entdeckung einer Population sehr massereicher Galaxien im jungen Universum mit dem James-Webb-Weltraumteleskop (JWST). Kurze Zeit nach dem Urknall sind die Massen dieser Galaxien unerwartet groß, was den theoretischen Erwartungen zu widersprechen scheint. Dr. Rahul Kannan analysierte die Vorhersagen von MillenniumTNG für diese frühe Epoche. Während die Simulationen bis zu einer Rotverschiebung von z=10 (als das Universum weniger als 500 Millionen Jahre alt war) mit den Beobachtungen übereinstimmen, bestätigte er, dass die neuen JWST-Ergebnisse bei einer noch höheren Rotverschiebung im Widerspruch zu den Vorhersagen der Simulationen stehen, falls sie Bestand haben. „Vielleicht ist die Sternentstehung kurz nach dem Urknall viel effizienter als zu späteren Zeiten, oder vielleicht sind damals massereiche Sterne in höheren Anteilen entstanden, was diese Galaxien ungewöhnlich hell macht“, erklärt Dr. Kannan.

Andere Arbeiten des Teams konzentrieren sich auf die Signale der Haufenbildung bei Galaxien. So erstellte die MPA-Doktorandin Monica Barrera extrem große und äußerst realistische Scheinkataloge von Galaxien auf dem rückwärtigen „Lichtkegel“ eines Referenzbeobachters (siehe Abbildung 3). In diesem Fall sind Galaxien, die weiter entfernt sind, automatisch auch jünger, was die Reisezeit des Lichts widerspiegelt, das unsere Teleskope erreicht. Anhand dieser virtuellen Beobachtungen untersuchte sie die so genannte baryonische akustische Oszillation (BAO) – ein kosmologisch wichtiges Standard-„Maßband“ – in der projizierten Zweipunkt-Korrelationsfunktion von Galaxien. Ihre Ergebnisse zeigen, dass die Messung dieser BAOs ein ziemlich kniffliges Unterfangen ist, das durch so-genannte kosmische Varianzeffekte erheblich beeinflusst werden kann – selbst wenn in Beobachtungen extrem große Volumina durchmustert und untersucht werden. Während man in Simulationen das modellierte Universum aus verschiedenen Blickwinkeln beobachten kann, um den korrekten statistischen Ensemble-Mittelwert zu ermitteln, ist dies für das reale Universum nicht ohne weiteres möglich. „Die MillenniumTNG-Simulationen sind so groß und enthalten so viele Galaxien – mehr als eine Milliarde in der größten Berechnung – dass es wirklich schwierig war, sie zu untersuchen“, sagt Monica Barrera. „Skripte, die für die Analyse kleinerer Simulationen gut funktionieren, brauchen für MillenniumTNG ewig.“

Analyse der kosmologischen Daten

Die Serie der ersten Ergebnisse der MillenniumTNG-Simulationen macht deutlich, dass die Berechnungen eine große Hilfe bei der Entwicklung besserer Strategien für die Analyse künftiger kosmologischer Daten sein werden. Der Leiter des Teams, Prof. Volker Springel vom MPA, führt an, dass „MillenniumTNG die jüngsten Fortschritte bei der Simulation der Galaxienentstehung mit dem Bereich der großräumigen kosmischen Struktur verbindet und eine verbesserte theoretische Modellierung ermöglicht, wie sich Galaxien mit dem Rückgrat der Dunklen Materie des Universums verbinden. Dies könnte sich als entscheidend für Fortschritte bei wichtigen Fragen in der Kosmologie erweisen, etwa wie die Masse von Neutrinos am besten mit Daten zur großräumigen Struktur eingeschränkt werden kann.“ Die MillenniumTNG-Simulationen lieferten mehr als 3 Petabyte an Simulationsdaten und bilden damit einen reichen Fundus für die weitere Forschung, die das Wissenschaftlerteam noch viele Jahre lang beschäftigen wird.