Supercomputer Simulationen der Entstehung der Galaxien und der ersten Quasare

Forschungsbericht (importiert) 2004 - Max-Planck-Institut für Astrophysik

Jüngste Fortschritte in der beobachtenden Kosmologie haben ein Standardmodell für die Anfangsbedingungen der Strukturbildung 380000 Jahre nach dem Urknall und für den Materieinhalt des Universums etabliert. Der größte Teil der heutigen Energiedichte (~ 70%) besteht demnach aus ,Dunkler Energie', einem mysteriösen Kraftfeld, das eine beschleunigte Ausdehnung des Alls antreibt. Etwa ein Viertel der Energiedichte besteht aus dunkler Materie, einem noch unbekannten, schwach wechselwirkenden Elementarteilchen, während nur etwa 5% in der Form normaler Atome (vor allem Helium und Wasserstoff) vorliegt. Anfängliche Fluktuationen in der Massenverteilung, die aus einer inflationären Epoche des sehr frühen Universums stammen, werden durch die Schwerkraft während der Ausdehnung des Universums verstärkt. Sie kollabieren schließlich und bilden die Galaxien, die wir heute beobachten. Um diesen hochgradig nichtlinearen und dreidimensionalen Prozess der gravitativen Instabilität nachzuvollziehen, kann man die Materie durch ein stoßfreies N-Körper-System repräsentieren, das sich unter Eigengravitation entwickelt. Allerdings ist diese Darstellung des Universums als ein N-Körper-System nur eine grobe Näherung, deren Genauigkeit sich aber verbessert, wenn die Anzahl der Teilchen erhöht wird. Es ist deshalb extrem wichtig, die Anzahl der Teilchen so groß wie möglich zu machen, soweit es der damit verbundene Rechenaufwand noch zulässt.

Unter der Leitung von Forschern des Max-Planck-Instituts für Astrophysik (MPA) ist es dem internationalen Virgo-Konsortium nun gelungen, eine neue Simulation dieser Art mit der größten jemals erreichten Teilchenzahl von 21603 = 1.0078 x 1010, mehr als 10 Milliarden, durchzuführen. Dies liegt eine Größenordnung über den umfangreichsten Rechnungen, die in diesem Gebiet bisher gemacht wurden und übertrifft den langfristigen Wachstumstrend solcher Simulationen deutlich, eine Tatsache, welche die beteiligten Wissenschaftler zum Namen „Millennium Simulation” für das Projekt inspiriert hat. Dieser Fortschritt wurde durch wichtige Verbesserungen in den eingesetzten Algorithmen des Simulationsprogramms sowie einem hohen Grad der Parallelisierung erreicht, sodass die Berechnung effizient auf 512 Prozessoren des IBM p690 Supercomputers des Rechenzentrums der Max-Planck Gesellschaft in Garching durchgeführt werden konnte. Allerdings waren die rechentechnischen Herausforderungen des Projekts dennoch erheblich. Der zusammengefaßte physikalische Speicher von 1~TB, der auf dem parallelen Computer insgesamt zur Verfügung stand, musste benutzt werden, und die Analyse der mehr als 20 TB an produzierten Daten erforderte die Entwicklung einer Reihe von neuartigen Methoden der Verarbeitung.

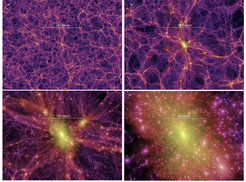

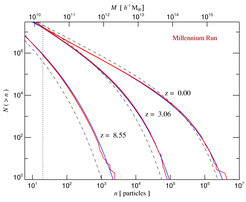

Das Simulationsvolumen ist ein periodischer Würfel mit einer Kantenlänge von 2230 Milliarden Lichtjahren, was zu einer Teilchenmasse von einer Milliarde Sonnenmassen führt, genug um eine Zwerggalaxie mit etwa einhundert Teilchen darzustellen, eine Galaxie von der Größe der Milchstraße mit etwa eintausend, und die massereichsten Galaxienhaufen mit mehreren Millionen. Die verschiedenen Bilder in Abbildung 1 geben einen visuellen Eindruck der heutigen Gestalt der Strukturen der dunklen Materie auf unterschiedlichen Skalen des Universums. Die Millennium-Simulation zeigt dabei eine vielfältige Population von Halos aller Größen, welche untereinander mit Filamenten aus dunkler Materie verbunden sind, sodass die Struktur eines Kosmischen Netzes entsteht. Die räumliche Auflösung der Simulation beträgt 5 h-1 kpc und steht überall in dem simulierten Volumen zur Verfügung. Der sich daraus ergebende dynamische Bereich von 105 pro Raumdimension erlaubt eine extrem genaue statistische Beschreibung der Strukturen im Universum, einschließlich der Auflösung von Substrukturen aus dunkler Materie innerhalb einzelner Halos. Abbildung 2 zeigt die nichtlineare Halo-Massenfunktion zu unterschiedlichen Epochen als ein Beispiel für die bemerkenswerte Genauigkeit, mit der Schlüsselgrößen der Kosmologie aus der Simulation gemessen werden können.

Eine wichtige Eigenschaft der Simulation ist ihre gute Massenauflösung, welche eine vollständige Auflistung aller Galaxien mit einer Leuchtkraft über 0.1 L* ermöglicht, obwohl ein Volumen abgedeckt ist, das dem der neuesten systematischen Beobachtungsprogrammen von Galaxien vergleichbar ist. Dies ist von großer Wichtigkeit, speziell um seltene Objekte geringer Raumdichte studieren zu können, beispielsweise massereiche Galaxienhaufen oder die ersten leuchtkräftigen Quasare bei hoher Rotverschiebung.

Um die physikalischen Prozesse der Galaxienentstehung zu verfolgen, wurden neuartige semi-analytische Methoden entwickelt und diese auf die Verschmelzunggeschichte von Halos aus der Millennium-Simulation angewandt. Dies ergibt ein mächtiges Werkzeug für die quantitative physikalische Interpretation der beobachteten Galaxienkataloge. Dazu werden in dem semi-analytischen Modell eine Reihe von Differentialgleichungen für die zeitliche Entwicklung der Galaxien, die die hierarchischen Verschmelzungsbäume bevölkern, integriert. Im wesentlichen beschreiben diese Gleichungen die Strahlungskühlung im kosmischen Gas, Sternentstehung, das Wachstum superschwerer Schwarzer Löcher, Rückwirkungsprozesse durch Supernova Explosionen und aktive Galaxienkerne, sowie Effekte einer ionisierenden ultravioletten Hintergrundstrahlung. Daneben wird die morphologische Entwicklung der Galaxien und die Anreicherung des kosmischen Gases mit schweren Elementen verfolgt. Für gegebene Annahmen über die Effizienz dieser Prozesse genügen dann wenige Stunden auf einem kleinen Cluster von Workstations, um die Positionen, Geschwindigkeiten und inneren Eigenschaften von allen Galaxien heller als die kleine Magellansche Wolke in einem Volumen vergleichbar dem von gegenwärtigen und geplanten Beobachtungsprogrammen vorauszusagen. Ein wesentliches Ziel, das durch diese Methodik möglich gemacht wird, ist die Bewertung unterschiedlicher Annahmen für die Physik der Galaxienentstehung durch den Vergleich mit Beobachtungsdaten, um auf diese Weise zu verstehen, welche dieser Prozesse die verschiedenen beobachteten Eigenschaften der wirklichen Galaxienpopulation bestimmen.

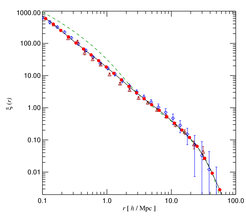

Die Leistungsfähigkeit dieses Ansatzes wird durch einige der ersten Ergebnisse eines Galaxienmodells demonstriert, das auf eine gute Beschreibung der beobachteten Eigenschaften der Galaxienpopulation bei niedriger Rotverschiebung eingestellt wurde. In Abbildung 3 zeigen wir die 2-Punkt -Korrelationsfunktion der Modellgalaxien und vergleichen sie mit Ergebnissen der 2dFGRS (2 degree Field Galaxy Redshift Survey) und APM (Automatic Plate Measuring Machine) Kataloge. Die Voraussagen zeigen ein fast perfektes Potenzgesetz, welches sich in guter quantitativer Übereinstimmung mit Beobachtungen befindet. Gleichzeitig reproduziert das Modell auch die beobachtete Abhängigkeit der Korrelationsfunktion von Leuchtkraft und Spektralfarbe der Galaxien. Dies ist ein bemerkenswerter Erfolg der Theorie der hierarchischen Galaxienentstehung basierend auf dem Modell der kalten dunklen Materie.

Diese Methode zum Studium der Galaxienentstehung erlaubt es auch, evolutionäre Verbindungen zwischen Objekten zu verschiedenen Epochen des Universums herzustellen. Beispielsweise wurde so vom Virgo-Konsortium gezeigt, dass Systeme mit der aus der Beobachtung von extrem hellen Quasaren bei Rotverschiebung z ~ 6 ableiteten Häufigkeit, Masse und Größe des superschweren Schwarzen Lochs sich tatsächlich in der theoretischen Simulation zu dieser frühen Zeit bilden können. Deren Vorläufersysteme waren bereits massereich bei Rotverschiebung z=16, während ihre Nachfahren zur heutigen Zeit die cD Galaxien im Zentrum großer Galaxienhaufen sind. Keine andere Simulation war bisher in der Lage, den Ursprung und das Schicksal solch seltener Objekte zu verfolgen. Abbildung 4 zeigt ein Beispiel eines solchen Quasar-Kandidaten bei Rotverschiebung z ~ 6.2 , welcher hier von der Galaxie mit der größten Sternmasse im ganzen Simulationsvolumen beheimatet ist. Die Galaxie befindet sich im Prozess heftiger Sternentstehung mit einer Rate von 235 Sonnenmassen yr-1. Ihr Nachfahre zur heutigen Zeit befindet sich im Zentrum eines großen Galaxienhaufens mit einer Masse von 2.0 x 1015 Sonnenmassen.

N-Körper-Simulationen des Modells der kalten dunklen Materie haben also nun eine solche Größe und Qualität erreicht, dass realistische Modelle der Galaxienentstehung in Raumgebieten von der Größe moderner Beobachtungsprogramme möglich geworden sind. Die weiteren Studien der Entwicklung von Galaxien und Quasaren, die den einzigartigen Datensatz der Millennium-Simulation ausschöpfen, werden neue stringente Tests der Theorie der hierarchischen Galaxienentstehung erlauben. Wenn man den bemerkenswerten Fortschritt kosmologischer Simulationen seit den 70er-Jahren um weitere drei Dekaden extrapoliert, können wir irgendwann um 2035 herum Simulationen mit 1020 Teilchen erwarten. Dies wäre dann ausreichend, um sogar jeden einzelnen Stern in einem Volumen so groß wie das der Millennium-Simulation mit einem eigenen Teilchen zu repräsentieren.